Sie sind hier:

Webinar - AI im inklusiven Recruiting: Chancen, Herausforderungen und Ethik

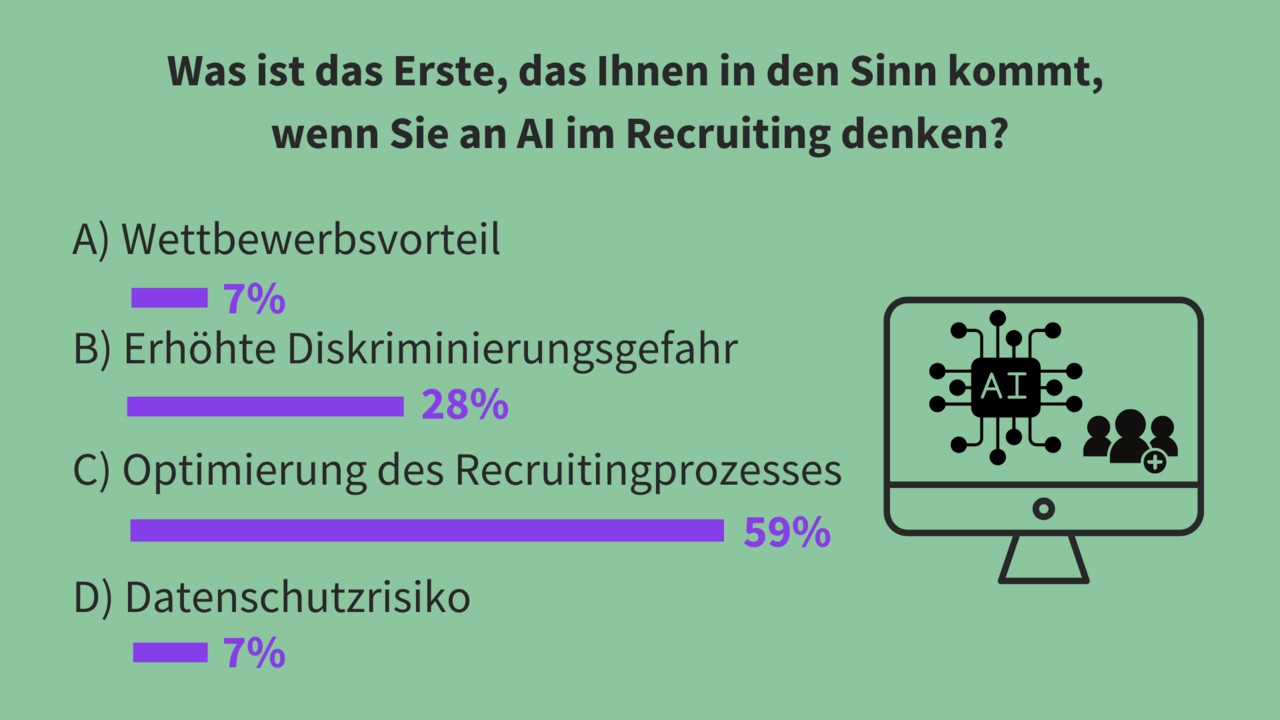

Zum Einstieg ins Thema gab es eine kleine Umfrage unter den Teilnehmenden. Die Frage lautete: Was ist das Erste, das Ihnen in den Sinn kommt, wenn Sie an AI im Recruiting denken?

Das Ergebnis zeigte, dass die Mehrheit der Teilnehmenden mit 59 % Künstliche Intelligenz als Möglichkeit zur Optimierung des Recruitingprozesses sehen. Eine erhöhte Diskriminierungsgefahr wurde im Vergleich nur von 28 % der Teilnehmenden als erster Gedanke gewählt. AI als Wettbewerbsvorteil oder Datenschutzrisiko fanden mit jeweils 7 % eine geringe Aufmerksamkeit.

AI, inklusives Recruiting und Ethik

Eine internationale Perspektive zum Thema Artificial Intelligence und Ethik kam von Amy Dickens, Policy Advisor am Centre for Data Ethics and Innovation. Zu Beginn ihres Vortrags räumte sie mit dem Mythos der AI als superintelligenter weltbeherrschender Roboter auf. Vielmehr ist es ein Bereich der Informatik zur Erforschung von aufgabenlösenden Maschinen verbunden mit menschlicher Intelligenz. Der Begriff AI umfallt viele verschiedene miteinander kombinierte Technologien wie beispielsweise Maschine Learning (deutsch: Maschinelles Lernen), aber auch Robotik. Maschine Learning generiert automatisiert Wissen, trainiert Algorithmen, identifiziert Zusammenhänge und unbekannte Muster. Dadurch werden Vorhersagen getroffen und Prozesse optimiert. Im Hinblick auf AI und Ethik nannte Amy Dickens neben den enormen Chancen wie Effizienzsteigerung, personalisierten Kundendienst sowie Verringerung menschlicher Fehler auch bedeutsame Risiken, die grundlegende gesellschaftliche Werte wie Sicherheit, Fairness, Privatsphäre und Handlungsfreiheit, Menschenrechte, gesellschaftliches Wohlergehen und Wohlstand bedrohen.

AI Ethik mit Hilfe des „Model for Responsible Innovation“

Die AI Ethics als Forschungs- und Praxisfeld sorgt gezielt dafür, die Vorteile von Künstlicher Intelligenz zu optimieren und gleichzeitig mögliche Risiken zu minimieren. Das Center for Data Ethics and Innovation (CFDE) unterstützt öffentliche und private Organisation durch Bereitstellung des „Model for Responsible Innovation“ beim ethisch verantwortungsvollen und vertrauenswürdigen Umgang mit Innovationen unter Verwendung von AI. Die wichtigsten Punkte aus dem Modell wie Sicherheit und Robustheit, Transparenz und Erklärbarkeit, Fairness sowie Rechenschaftspflicht sind im Whitepaper der britischen Regierung zur KI-Regulierung zu finden.

Anwendungsbereiche der AI im Recruiting

AI wird im Bewerbungsprozess für Aufgaben wie Sourcing, Screening, Vorstellungsgespräch und Auswahl von Bewerber:innen eingesetzt. Das soll zur Effizienz, Skalierbarkeit und Konsistenz beitragen. Doch es entstehen auch zahlreiche Risiken wie diskriminierende Stellenausschreibung und Zielgruppenansprache, den Erhalt bestehender Vorurteile, digitale Ausgrenzung sowie diverse Datenschutzproblematiken. Als Gegenmaßnahme hat das CFDE gemeinsam mit dem REC – Recruitment and Employment Confederation (britischer Branchenverband der Personalvermittlungsbranche) einen Leitfaden zur Anschaffung und Nutzung datengesteuerter Technologien wie AI entwickelt. Dieser beinhaltet Gesetze, Normen und Grundsätze im Hinblick auf die Künstliche Intelligenz im HR-Bereich.

Der Weg zum inklusiven Recruiting

Pia Leichtfried, Talent Managerin bei myAbility, gab wichtige Tipps und Empfehlungen zum Thema inklusives Recruiting. Sie sieht es als essentiell, dass alle Bewerber:innen Zugang zum Bewerbungsprozess und allen dazugehörigen Informationen haben. Wichtig ist in diesem Zusammenhang die Verwendung einer inklusiven Ansprache in Jobausschreibungen, die Web Accessibility von Karriereseiten sowie die Barrierefreiheit bei Bewerbungsgesprächen. In einer inklusiven Stellenausschreibung steht zu Beginn immer die ausdrückliche Aufforderung an Personen mit Behinderungen und chronischen Erkrankungen sich zu bewerben. Zusätzlich ist es wichtig am Ende des Inserates die Kontaktperson für Barrierefreiheit anzugeben. Ein barrierefreies Layout im Hinblick auf Schriftgröße, Kontraste und Ausfüllbarkeit von Formularen ist ein weiterer wichtiger Schritt zur inklusiven Ansprache. Zusätzlich sollen sich Unternehmen stets flexible zeigen und auf individuelle Situationen im Bewerbungsprozess eingehen können.

Technische Barrierefreiheit auf Karriereseiten

Viele Unternehmen verwenden nach wie vor keine barrierefreien Technologien auf ihren Karriereseiten. Somit sind diese beispielsweise nicht kompatibel mit Screenreadern und barrierefreie Bewerbungsunterlagen können meist nicht hochgeladen werden. Doch barrierearme, kostengünstige, technologische Alternativen existieren bereits und kommen auch immer wieder zur Anwendung. Virtuelle Bewerbungsgespräche sind sehr barrierefrei und ein gutes Beispiel dafür, dass von Barrierefreiheit viele profitieren. Besonders für Bewerber:innen mit Mobilitätseinschränkungen ist ein Online-Gespräch überaus hilfreich. Zusätzlich bieten Videokonferenzprogramme eine Untertitelfunktion. Dadurch wird es Menschen mit Höreinschränkungen ermöglicht, auch ohne Gebärdensprachdometscher:innen am Gespräch teilzunehmen.

Ein Webinar zum Thema Barrierefreie Karriereseiten ist hier zu finden:

Barrierefreie Karriereseiten. Der Schlüssel zu Ihrem Recruiting-Erfolg.

Automatisierung durch AI im Recruiting

Ein wissenschaftlicher Einblick zu AI im Recruiting wurde von Peter Purgathofer, Professor an der Fakultät für Informatik an der Technischen Universität Wien, gegeben. Sein Vortrag befasste sich mit der Automatisierungsunterstützung in der Entscheidungsfindung und hinterfragte die Anwendung von Künstlicher Intelligenz im Recruiting. Zu Beginn präsentierte er einen Artikel von Lisanne Brainbridge mit dem Titel „Ironies of Automation“ von 1983 und demonstrierte damit gleich die Tücken von AI anhand des Fotos von der Autorin. Beim Versuch ein Bild aus dem Internet mit Wasserzeichen von ihr durch AI zu bearbeiten, generierten die Programme ausschließlich unpassende Darstellungen von Brainbridge. Im Aufsatz werden Industrieunfällen durch die Ironie der Automatisierung erklärt. (Ironies of Automation) Das zeigt beispielhaft auf, dass Automatisierung immer einen Preis hat, sowohl individuell als auch gesellschaftlich.

AI als Automatisierungsunterstützung bei der Auswahl von Bewerber:innen

Künstliche Intelligenz wird im Recruiting mittels Systemen wie ATS – Applicant Tracking Software zur systematischen Vorauswahl und Filterung von potenziellen Bewerber:innen verwendet. Doch diese Anwendung führt zu drei wesentlichen Problemen.

- Die Fokussierung des Systems auf gewisse Attribute im Dokument wie zum Beispiel vorgetäuschte Qualifikationen in weißer Schrift im Lebenslauf, die nur die AI wahrnimmt und dadurch Kandidat:innen als qualifizierter einstuft als sie sind. Auch die Verwendung von ChatGPT für Motivationsschreiben stützt diese Problematik. Nutzen Bewerber:innen AI zur Erstellung ihrer Bewerbungsunterlagen und Recruiter:innen die Künstliche Intelligenz zum Filtern der Bewerbungen, kommt es zu einer Eskalationsspirale durch gegenseitige Täuschung.

- Die Systeme haben immer einen Bias. Das bedeutet, dass diese vorurteilsbehaftet sind und nicht unbedingt objektiv auswählen. Das kann zum Ausschluss von diversen Personen führen. Weiters ist nicht klar, wie AI Systeme Entscheidungen treffen, weil diese weder begründet noch erklärt werden, aufgrund der Funktion als undurchsichtige Blackbox. Zusätzlich weiß man nicht, was ursprünglich die Kriterien als Trainingsmaterial waren, auf denen die Maschine Learning Programme aufbauen. Es passiert also abstrakt und mathematisch statt konkret und menschlich. Manche Systeme wollen auch nicht preisgeben, wie sie ihre Entscheidungen treffen im Sinne eines Geschäftsgeheimnisses oder einfach durch Zufallsauswahl.

- Grundlegend ist zu überdenken, ob Computer überhaupt Entscheidungen über menschliche Eigenschaften treffen sollten. Als Beispiel hierfür nennt Purgathofer die Arbeit von Arvind Narayanan von der Princeton University mit dem Titel „How to recognize AI snake oil“. Er vergleicht in seinem Artikel die AI mit einem vielversprechenden, gut verkäuflichen Hype, der nicht das beinhaltet, was er verspricht. Dabei handelt es sich meistens nur um Maschine Learning Systeme, die als AI gelabelt werden. Das bedeutet für den Bewerbungsprozess, dass Zufallsauswahlen getroffen werden. Das kann wiederrum zum Ausschluss von Bewerbungen führen und ist somit nicht inklusiv. Die menschliche Kontrolle fehlt dabei völlig. Es gibt daher Vorhersagen, die nicht von AI getroffen werden sollten, nämlich das Ergebnis von sozialen, menschlichen Situationen wie die Rückfälligkeitsquote von Straftätern oder die Arbeitsleistung. Zum selben Schluss kamen bereits 40 Jahre zuvor die Autoren des Artikels „Dilemmas in a General Theory of Planning“ Rittel und Webber, nämlich dass soziale Entscheidungen nicht mathematisch modellierbar sind.

Richtlinien im Entscheidungsprozess

- Menschen entscheiden lassen, diese können auch die Verantwortung tragen.

- Situationen schaffen, in denen Menschen sinnvollerweise entscheiden müssen.

- Training der Menschen für diese Art der Entscheidungen, um Vorurteilen entgegenzuwirken.

Durch die Kombination von verschiedenen Systemen im Bewerbungsprozess kann das realisiert werden. Jedoch nur, wenn die finale Entscheidung inklusive Auswahl beim Menschen liegt. Dadurch werden die Entscheidungen nicht der AI übertragen, sondern diese nur als Unterstützung im Entscheidungsprozess genutzt.

Zusammenfassend ergeben sich daraus drei konkrete Handlungsempfehlungen.

Tipp #1: Die finale Entscheidung beim Menschen belassen.

Tipp #2: Die Defizite von AI im Blick behalten.

Tipp #3: Mehrere AI-Programme vergleichend nutzen.

Mit freundlicher Unterstützung